Innholdsfortegnelse:

- Forfatter John Day day@howwhatproduce.com.

- Public 2024-01-30 11:21.

- Sist endret 2025-01-23 15:02.

Dette prosjektet tar sikte på å fange bevegelsen til det menneskelige øyet, og viser bevegelsen på et sett med LED -lys som er plassert i form av et øye. Denne typen prosjekter kan potensielt ha mange bruksområder innen robotikk og spesielt humanoider. Som et eksempel kan en person projisere øynene på ansiktet til en robot som samhandler med andre mennesker uansett formål. Dette kan gi en robot et mer livaktig utseende ettersom øynene etterligner noens faktiske øyebevegelse. Dette prosjektet innebærer bare å vise ett menneskelig øye på et LED -øye, så jeg er spent på å se hvilke andre ideer folk har for å fremme dette prosjektet enda mer.

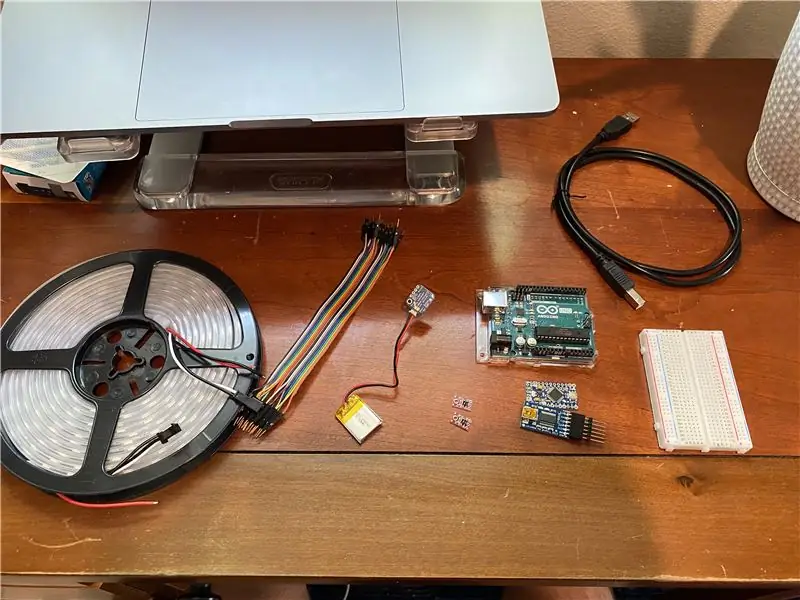

Rekvisita

1. Arduino Uno Board (sørg for å kjøpe USB -kabel for å koble til datamaskin)

store.arduino.cc/usa/arduino-uno-rev3

2. Brødbrett (trenger ikke et veldig stort; gjør tilkobling av ledninger enklere)

www.pololu.com/product/351

3. Adafruit LiIon/LiPoly ryggsekk-tillegg for Pro Trinket/ItsyBitsy og 3.7V batteri

www.adafruit.com/product/2124

4. NeoPixel LED Strip (kjøp hele hjulet)

www.adafruit.com/product/1138?length=4

5. QTR-1A refleksjonssensor

www.pololu.com/product/2458

6. Pakning av ledninger: Hann/Mann (gjør det enklere å koble til komponenter)

www.adafruit.com/product/759

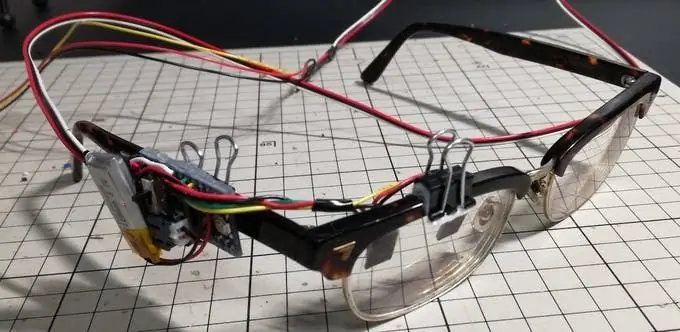

7. Eventuelle briller (briller, solbriller, etc. Se bilder for referanse)

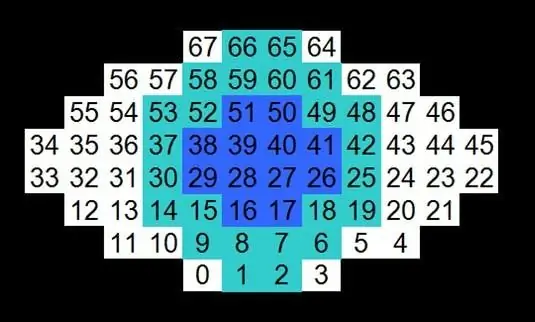

Trinn 1: Lay -out og Wire LED -er i øyeform

Basert på bildene som er vedlagt dette trinnet, koble LEDene i den viste rekkefølgen. Lysdiodene kan legges flatt på en overflate eller festes med tape til et sfærisk objekt for bedre å representere et faktisk øyeeplet.

Trinn 2: Skriv Arduino -kode og last opp til bord

Den vedlagte filen for dette trinnet inneholder all koden som er nødvendig for å vise øyebevegelsen på lysdiodene. Det er to biblioteker inkludert i koden, og de finnes på Github -koblingene nedenfor. Spill med koden og se hvilke andre kule funksjoner som kan implanteres. Når koden er fullført, må du kontrollere at den kompileres og deretter lastes opp til Arduino Uno -kortet.

QTRsensors.h:

Adafruit_NeoPixel.h:

Forklaring av koden:

Når iris nærmer seg en sensor, reduseres det reflekterte lyset og sensorverdien øker. Motsatt, når iris beveger seg bort, øker det reflekterte lyset og sensorverdien til fotoreflektoren synker. Høyre og venstre bevegelse av eleven til LED -øyeeplet registrerer økning og reduksjon av en sensorverdi og kontrollerer den. Når de blinker, reduseres begge sensorverdiene, så hvis de to sensorverdiene synker samtidig, vil øyelokkene til LED -øyebollet gå ned.

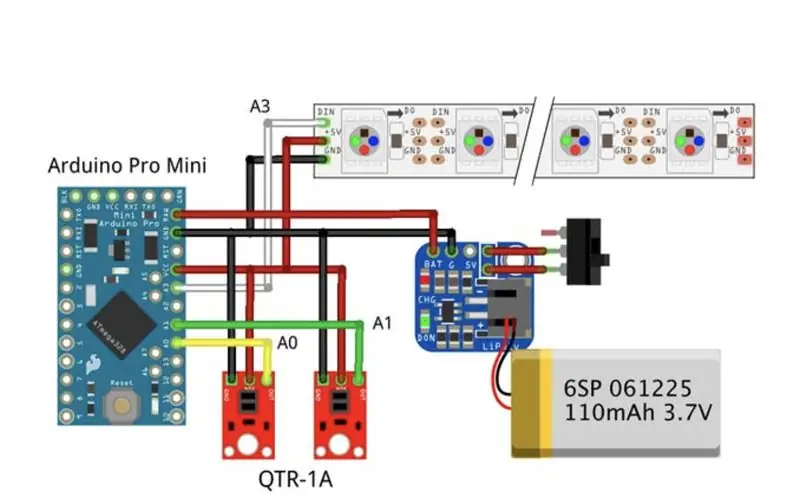

Trinn 3: Koble til sensorer/komponenter

Basert på det vedlagte bildet, koble hver komponent til Arduino Uno -kortet. Et brødbrett kan brukes til å gjøre tilkoblingene enklere, men ikke nødvendigvis nødvendig. Lodding av ledningene til komponentene fungerer også.

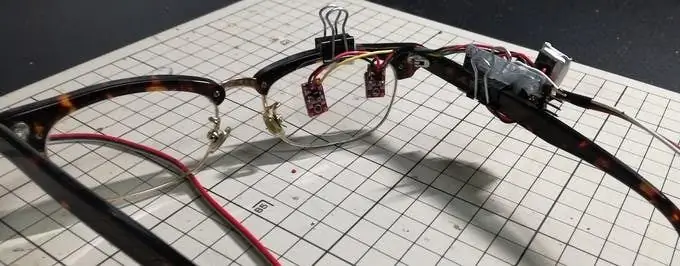

Trinn 4: Fest sensorer/ledninger til briller

De to QTR - 1A -sensorene er plassert i en avstand på omtrent bredden på øyet på en av brilleglassene. Det er det eneste utstyret som må være på det stedet. Resten kan festes til brillene som du ønsker. Bare husk at sensorene må plasseres på linsen foran øyet. Noen mindre posisjonsjusteringer kan være nødvendig basert på hvordan forskjellige menneskers ansiktsstrukturer passer til brillene.

Trinn 5: Videopresentasjon om prosjektet

Dette er en video av min presentasjon av prosjektet for Humanoids -klassen min ved Carnegie Mellon University. I videoen diskuterer jeg noe av inspirasjonen og formålet med prosjektet. I tillegg forklarer jeg detaljene om hvordan prosjektet skal fullføres, samt forklarer en del av Arduino -koden. Jeg viser også hvordan det endelige resultatet av prosjektet skal se ut mot slutten av videoen.

Trinn 6: Hvordan forbedre resultatene mine

Hvis du leter etter en virkelig utfordring, anbefaler jeg på det sterkeste å ta dette prosjektet og prøve noe litt annerledes for å forbedre/legge til det. Dette prosjektet er et flott utgangspunkt for mer ambisiøse og utfordrende prosjektideer. For folk som er interessert i å ta dette prosjektet til neste nivå, har jeg tenkt på noen få måter å gjøre det på. Jeg vil liste disse ideene nedenfor:

1. Dupliser dette prosjektet på det andre objektivet slik at begge menneskelige øyeboller kan vises på to sett med lysdioder.

2. Legger til ide 1, men finner deretter ut en måte å projisere bevegelsen til en munn på lysdioder.

3. Legger til ide 2, men finn deretter ut hvordan du projiserer på hele ansiktet på et sett med lysdioder (øyne, munn, nese, øyenbryn)

4. Finn en annen menneskelig kroppsdel hvis bevegelse kan registreres og deretter vises på lysdioder (håndbevegelse, armbevegelse, etc.)

Anbefalt:

Head Motion Tracking System for VR: 8 trinn

Head Motion Tracking System for VR: Jeg heter Sam KODO, I denne veiledningen vil jeg lære deg trinn for trinn hvordan du bruker Arduino IMU -sensorer til å bygge hodesporingssystem for VR. I dette prosjektet trenger du: - En LCD -skjerm HDMI : https: //www.amazon.com/Elecrow-Capacitive-interfac…- En

Hvordan bruke Detect Human HC-SR501: 9 trinn

Hvordan bruke Detect Human HC-SR501: En opplæring for å utvikle Detect Human HC-SR501 med skiiiD

"Detroit: Become Human" Android LED -ring: 5 trinn

"Detroit: Become Human" Android LED -ring: Hei! Jeg skal på Anime Expo i helgen, og jeg ville cosplaye som Android fra mitt nåværende favorittspill, Detroit: Become Human. Det er en av de enkleste cosplays å lage … eller så tenkte jeg. Du skjønner, jeg pusler med ting her og der, men når

Eye Guardian: Sound Triggered Eye Protection: 9 trinn (med bilder)

Eye Guardian: Sound Triggered Eye Protection: Eye Guardian er en Arduino-drevet, høy-decibel kontinuerlig lyd som utløser slitasje på øyebeskyttelse. Den oppdager lyd fra tungt utstyr og senker beskyttelsesbriller mens utstyret er i bruk. Oversikt I det første trinnet vil jeg forklare Inspirati

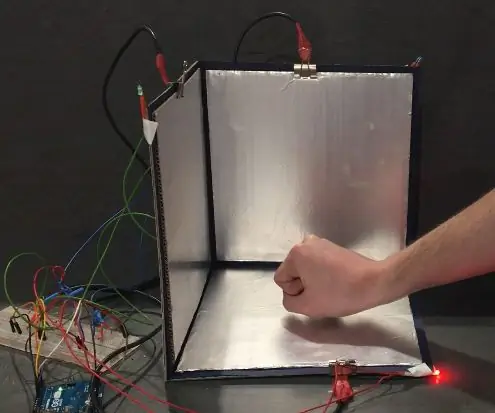

Tfcd 3D Motion Tracking Through Capacitive Sensing og LED Output: 6 trinn (med bilder)

Tfcd 3D Motion Tracking Through Capacitive Sensing og LED Output: I denne instruksjonen forklares hvordan bevegelsen av en hånd kan spores i et 3D -rom ved å bruke prinsippet om kapasitiv sensing. Ved å endre avstanden mellom en ladet aluminiumsfolie og hånden din, vil kapasiteten til kondensatoren variere